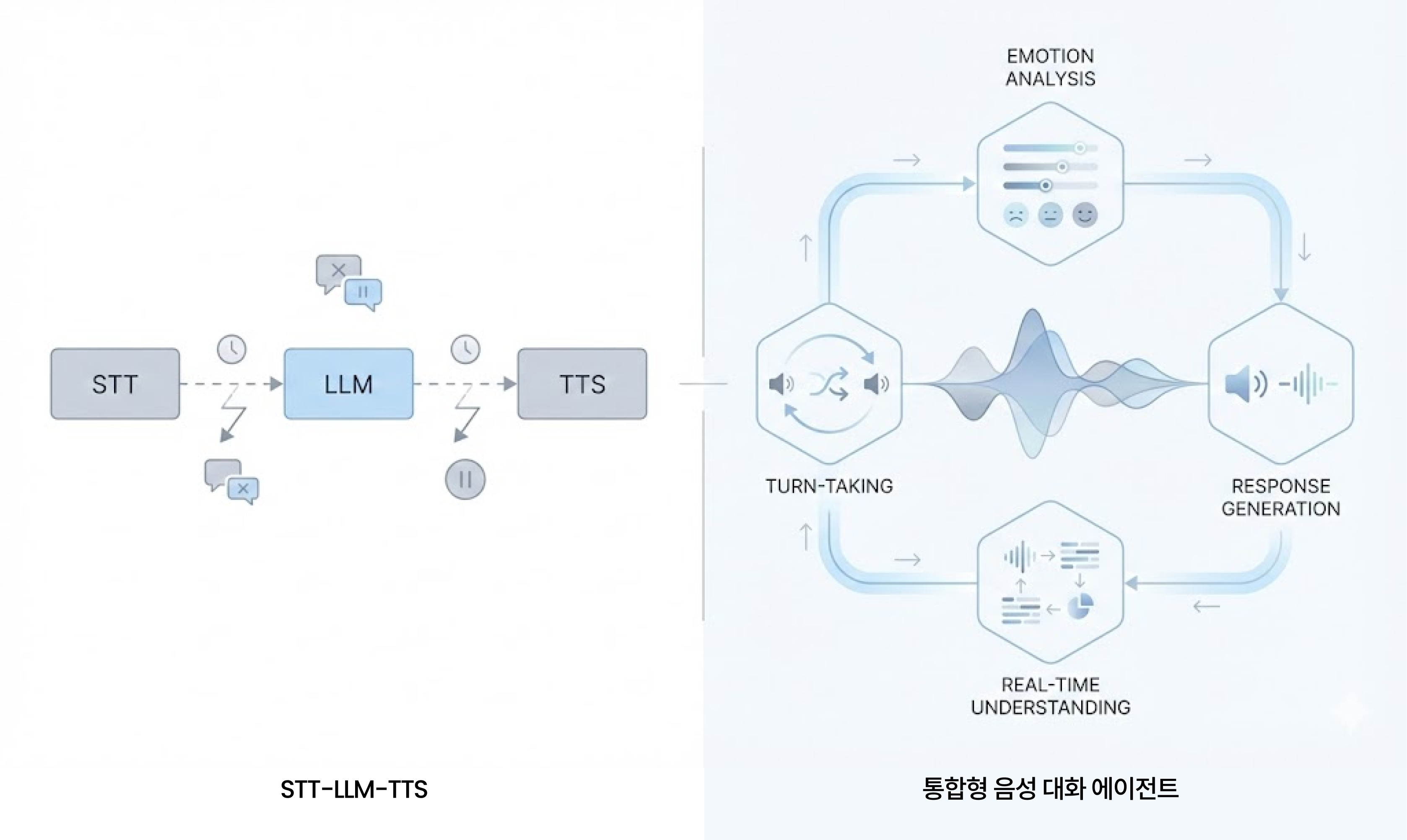

음성 대화 에이전트는 STT-LLM-TTS를 연결하는 것만으로는 상용화되기 어렵고,음성 신호·대화 흐름·감정과 맥락을 통합적으로 이해하는 구조가 필요합니다. MAGO는 지난 2년간의 실제 협업 사례를 통해, ‘대화를 하는 AI’에서 ‘대화를 이해하는 AI’로 나아가기 위한 기술 조건을 검증해왔습니다.

💡 음성 대화 에이전트란?

음성 대화 에이전트(Voice Conversational Agent)는 단순히 말을 텍스트로 바꾸고 답변을 읽어주는 시스템이 아니라, 사람의 말투, 감정, 맥락, 대화 흐름을 이해하며 상호작용하는 AI 시스템을 의미합니다.

MAGO(마고)는 지난 2년간, 네이버 클라우드와 한국 에자이와의 협업을 통해 이러한 음성 대화 에이전트가 실제 서비스 환경에서 어떤 역할을 할 수 있는지, 그리고 시장이 무엇을 요구하고 있는지를 단계적으로 검증해왔는데요.

마고의 음성 기술은 문장의 의미 분석을 넘어, 수집되는 음성 신호로부터 정서 변화, 발화 패턴, 인지 저하 가능성과 같은 비언어적 정보를 함께 분석하는 데 초점을 두고 있습니다.

🖇️ 왜 STT-LLM-TTS만으로는 상용 서비스가 어려울까

많은 경우 음성 대화 에이전트는 STT → LLM → TTS 구조만 연결하면 구현할 수 있다고 생각됩니다. 하지만 실제 서비스 환경에서는 이 방식만으로는 한계가 분명하죠.

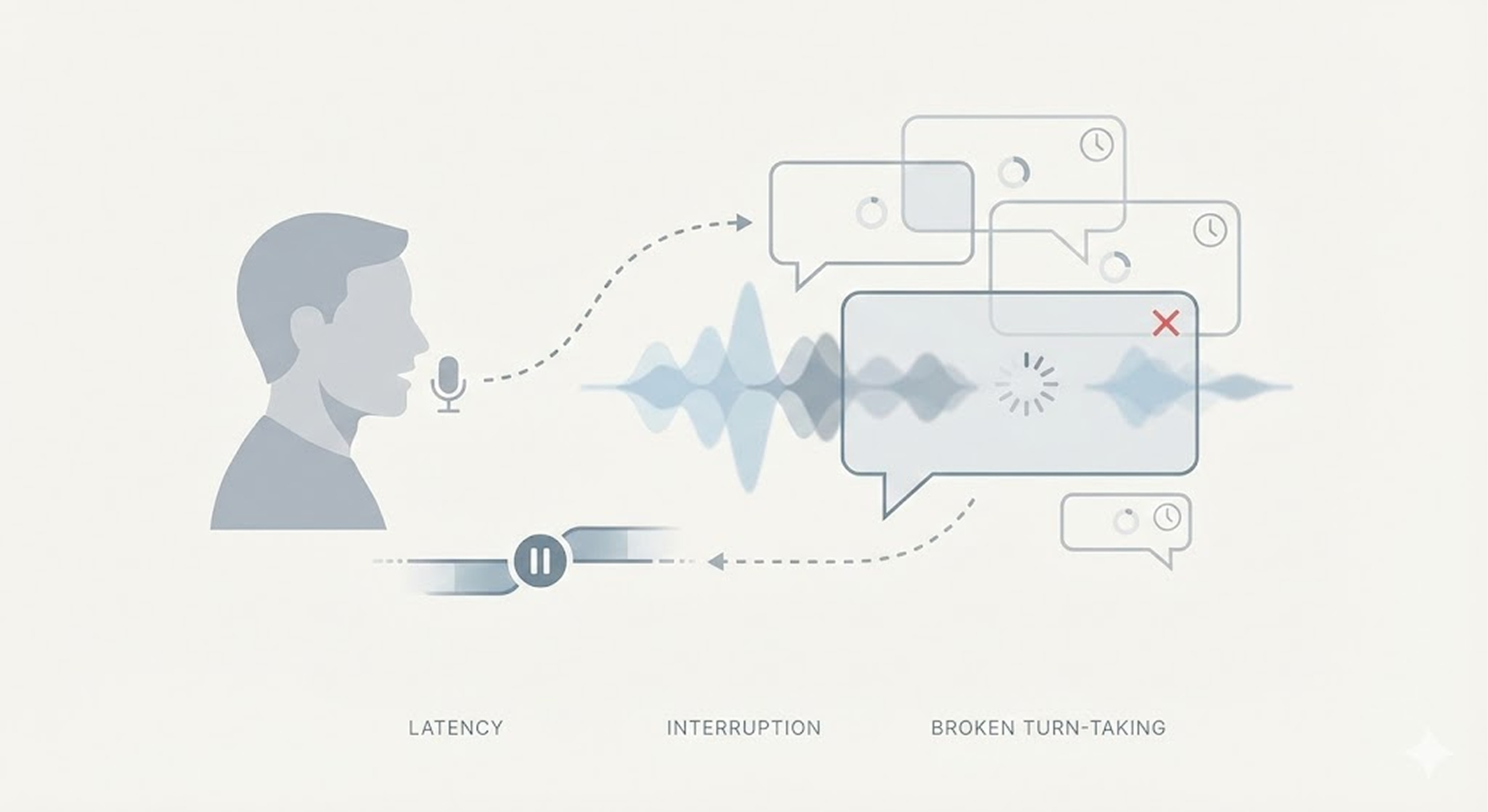

1) 지연 시간의 벽 (Latency)

사람 사이의 대화에서 자연스러운 응답 간격은 보통 200~500ms입니다. 하지만 STT, LLM, TTS를 순차적으로 거치면 다음과 같은 지연이 누적됩니다.

STT: 발화 종료 인식(End-pointing) 지연

LLM: 추론 및 첫 토큰 생성 시간

TTS: 음성 합성 및 출력 준비 시간

전체 지연이 2~3초를 넘어가면, 사용자는 “내 말을 들은 게 맞나?”라는 불안감을 느끼기 시작하고, 대화 흐름이 쉽게 끊어집니다.

2) 끼어들기와 침묵 처리의 문제 (Turn-taking)

단순 파이프라인 구조에서는 사람의 자연스러운 대화 리듬을 처리하기 어렵기 마련입니다.

사용자가 말을 끊는 경우(Barge-in)

“음…”, “아니 그러니까” 같은 중간 발화

생각하다 잠시 멈추는 침묵 구간

이 과정에서 Full-duplex 처리, 정교한 VAD, 실시간 판단이 부족하면 에이전트는 쉽게 대화를 놓치기 쉽죠.

3) 음성 고유 정보의 부재

텍스트 기반 LLM은 목소리 톤, 감정, 말하는 속도, 떨림 같은 음성 고유 정보를 다루지 못합니다.

화가 난 목소리도 평범한 문장으로 처리되고

슬픔이나 피로는 의미에서 사라지며

TTS 역시 감정 맥락 없는 ‘낭독’에 머무르게 됩니다.

하지만 실제 대화에서 이 정보들은 의미만큼 중요한 판단 기준이 되죠.

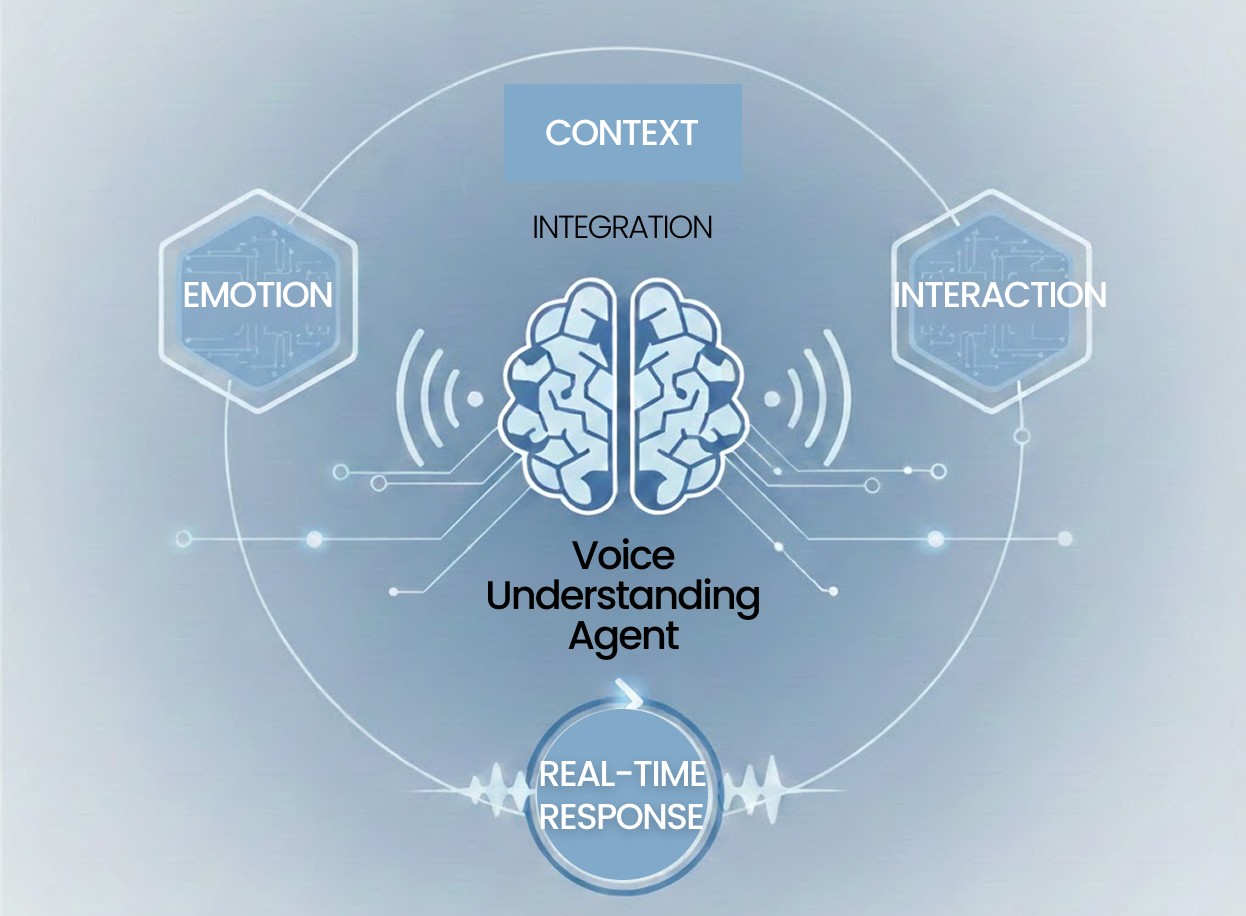

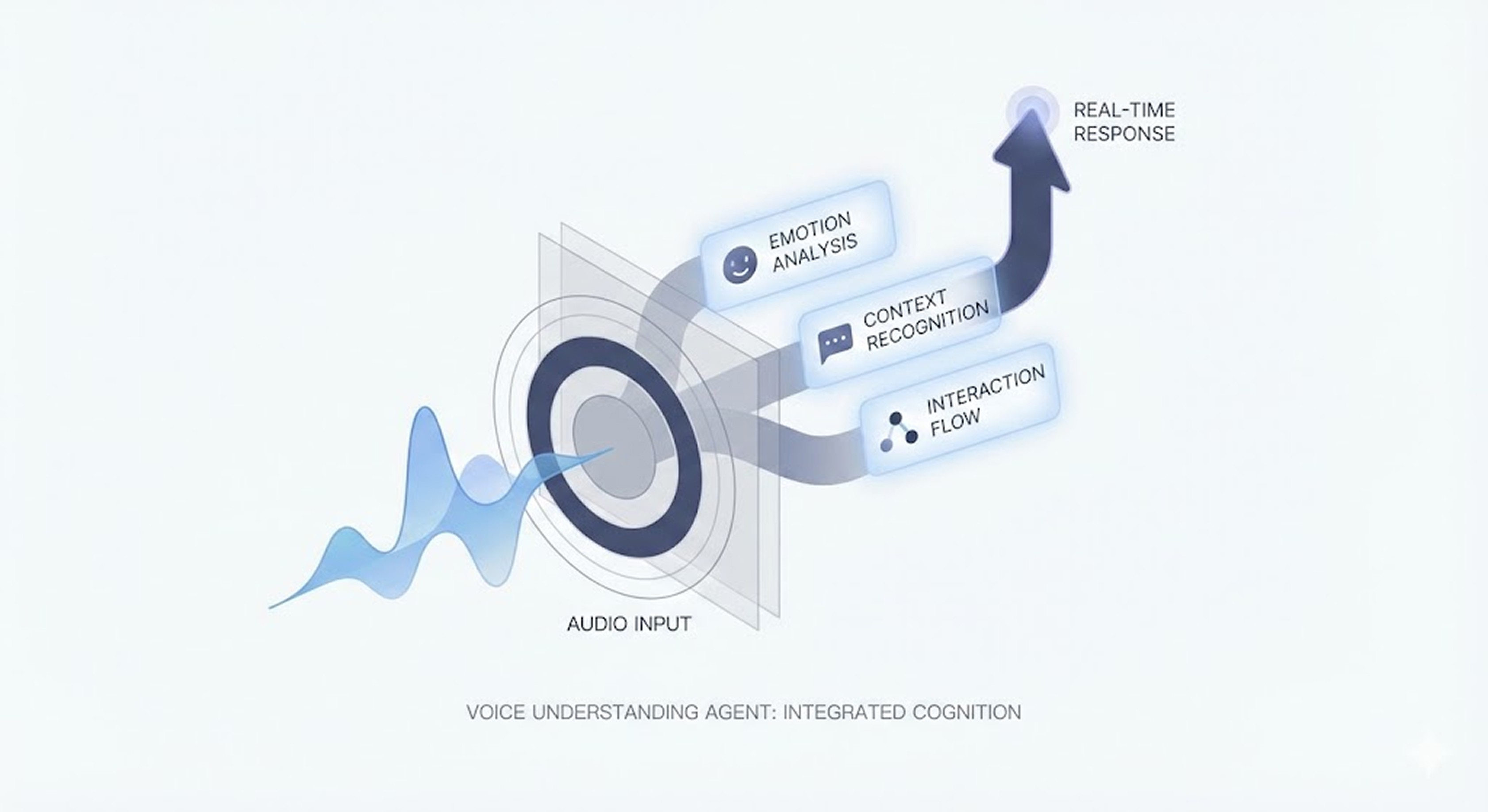

🔒 연결이 아니라 ‘통합’의 문제

결국 음성 대화 에이전트의 핵심은 모델을 연결하는 것이 아니라, 음성 신호, 인식, 이해, 반응을 하나의 구조로 통합할 수 있는가에 있습니다. “사용자의 말을 처리하는가”가 아니라 “사용자의 호흡과 상태를 실시간으로 읽고 반응할 수 있는가”가상용 서비스의 성패를 가르게 됩니다.

🔎 MAGO가 이 문제를 검증해온 방식

▶️ 네이버 클라우드 ‘클로바 케어콜’ PoC

2024년 마고는 네이버의 음성 돌봄 서비스 ‘클로바 케어콜’과 협업하여 전화 통화를 통해 우울 및 치매 가능성을 선별하는 PoC를 진행했습니다. 케어콜은 대상자에게 정기적으로 전화를 걸어 건강, 식사, 수면 등 일상 상태를 확인하는 AI 기반 돌봄 서비스입니다.

마고는 여기서 단순한 안부 확인을 넘어, 통화 중 음성 신호에 나타나는 정서 변화, 발화 패턴, 반응 지연을 분석해 인지 저하 및 우울 가능성을 조기에 포착할 수 있는지를 검증했습니다.

▶️ 한국에자이 협업 & ILS Tokyo 참가

2025년에는 한국에자이(Eisai)와 함께 ‘음성 기반 인지 기능 평가 플랫폼’이라는 비전을 공유하며 협업을 진행했는데요. AI 대화를 통해 어르신들의 언어 특성, 감정 변화, 반응 패턴을 분석하고, 이를 기반으로 인지 저하 가능성을 조기에 탐지하는 접근입니다. 이 과정에서 마고는 한 가지 분명한 사실을 확인했습니다. 많은 시니어들은 병원 방문이나 검사에 부담을 느끼고, 화면을 조작하는 서비스보다 자연스러운 대화를 통한 상호작용을 훨씬 편안하게 받아들인다는 점입니다.

이런 환경에서 음성 대화 에이전트는 단순 인터페이스가 아니라, 일상 속 상태 변화를 감지하는 센서에 가까운 역할을 하게 되죠. 또한 이러한 기술 특성 덕분에 시니어 케어 영역에서 AI가 빠르게 확산되고 있는 일본 시장에서도 큰 관심을 받았고, 2025년 ILS 행사에서도 이를 다시 확인할 수 있었습니다.

🔈MAGO가 만들고 있는 음성 대화 에이전트

마고가 지향하는 음성 대화 에이전트는 대화를 ‘처리’하는 시스템이 아니라, 대화를 이해하는 구조에 가깝습니다.

음성 신호 기반 감정·상태 분석

발화 흐름과 반응 패턴 이해

실시간 상호작용 구조

클라우드뿐 아니라 온디바이스 환경까지 고려한 설계

마고는 음성을 “텍스트 이전의 데이터”로 보고, 그 안에 담긴 인간적 신호를 기술적으로 해석하는 데 집중하고 있습니다. 그리고 지난 2년간의 협업 사례는, 이 방향성이 실제 서비스 환경에서도 의미가 있다는 점을 조금씩 증명해온 과정이었습니다. 마고는 앞으로도 현장에서의 협업과 검증을 통해, 음성 대화 에이전트가 ‘대화를 하는 시스템’을 넘어 ‘대화를 이해하는 구조’로 발전할 수 있는 가능성을 계속해서 확인해 나갈 예정입니다.